RESEARCHER研究者リスト

※2024年度当時の所属で表示しています

研究代表者情報科学部 情報メディア学科村木 祐太 准教授

研究分担者

情報科学部

ネットワークデザイン学科

杉川 智 准教授

研究分担者

情報科学部

情報知能学科

小谷 直樹 准教授

OVERVIEW研究課題の概要

近年,スマートフォンやタブレット等,様々な画面サイズのデバイスが普及し,それに伴い静止画像や動画像に対するリサイズの需要が高まっている.リサイズ手法は,スケーリングのようにアフィン変換を用いて画像を伸縮させる手法,クロッピングのように画像の一部をトリミングする手法,シームカービング(以下,SC)のように画像の不要な画素を除去することでリサイズする手法に大別され,多くの研究がなされている.しかし,図1に示すように動画像に対するリサイズは,手法によっては動画像の印象を損なう場合がある.また,映りこむ被写体の数,大きさ,動きといった要素に大きく依存し,違和感のないリサイズが可能な動画像は限定的である.特にクロッピングやSCでは,リサイズ手法をフレームごとに独立して適用した場合,被写体位置がフレーム間でずれてしまう“位置ずれ”や被写体の歪み,オブジェクトの不自然な消失が発生してしまう.これにより,動画像の印象やメッセージ性が損なわれる可能性がある.さらに,動画像に対するリサイズ手法は計算コストが高くなるため,リアルタイムでの処理が困難な問題がある.適切なトリミング領域の選択や削除画素の算出によって,動画像の違和感を抑制したリサイズが可能ではあるが,そのアルゴリズムは確立されていない.

本研究では,顕著性や被写体の動き,カメラの移動量に着目し,前後のフレームでトリミング領域や削除領域に整合性をもたせることで,汎用的かつ高精度な動画像のリサイズ技術を実現する。

本プロジェクトでは以下の2テーマを扱う.

(テーマA)複数被写体を考慮した縦型ビデオクロッピング

(テーマB)被写体の動きに基づいたシーム制御による高精度な動画像シームカービング

REASON課題実施の根拠

(テーマA)

提案手法では,被写体を検出した後,各被写体の運動量と深度値を基に主被写体を決定する.そして,主被写体の顕著性座標を基にクロッピングを施す

被写体検出では,動画像内の物体を検出した後,バウンディングボックス(以下,BB)内の顕著性と鮮明度によって物体を削減する.顕著性検出にはUNISAL[1]を用いる.これらの処理により,顕著性が存在し,鮮明度が閾値以上のBBが被写体となる.主被写体検出では,検出された被写体から,主被写体を決定する.運動量が大きいBBと動画内の手前に存在するBBは重要な被写体であるとして,運動量と深度値を用いたコストとなるsubject_costを算出する.subject_costは,BB内における平均運動量と平均深度値を正規化し,それぞれに重みを積算してから加算することで算出する.算出されたsubject_costが最も高いBBが主被写体として決定される.クロッピングでは,主被写体の動きに合わせ,クロッピング位置を取得する.クロッピング位置は主被写体の顕著性が最大の座標とする.また,クロッピング位置の動きを動画全体に渡って滑らかにするため,時系列の平滑化を施す.これにより,水平方向のブレを抑制したクロッピングを実現する.

(テーマB)

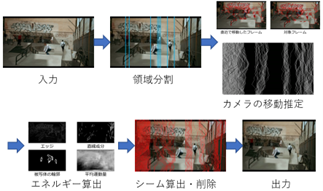

提案手法では,はじめに,物体検出・追跡を用いて対象フレームを複数の領域に分割する.次に,対象フレームのカメラ移動の有無を判定する.その後,画像の特徴を表すエネルギーマップを算出する.最後に,分割結果とエネルギーマップをもとにシームを算出し,削除する.

領域分割では,被写体のBBをもとに対象フレームを分割し,分割位置の変化から対象領域の変化の有無を判定する.領域分割では,まず,物体検出・追跡を用いて各被写体のBBを取得する.次に,BBの出現頻度,顕著性,鮮明度,大きさを基に重要でない被写体のBBを削減する.その後,動画像全体のBBの位置変化から被写体の動静領域を抽出する.

最後に,動的領域内のBBの位置と動静領域の境界位置を分割位置とする.また,エッジ,直線成分,被写体の輪郭,平均運動量をもとにエネルギーマップを算出し,動的計画法を用いてコストが最小となる経路を算出し,シームとする.また,カメラが移動していない場合,前フレームと比較して分割位置に変化が無い領域でシームを再利用する.そして,算出したシームを削除することで,対象フレームをリサイズする.

図1 動画像に対するリサイズ処理

図2 クロッピング処理

図3 SC処理

図4 入力動画像(テーマA)

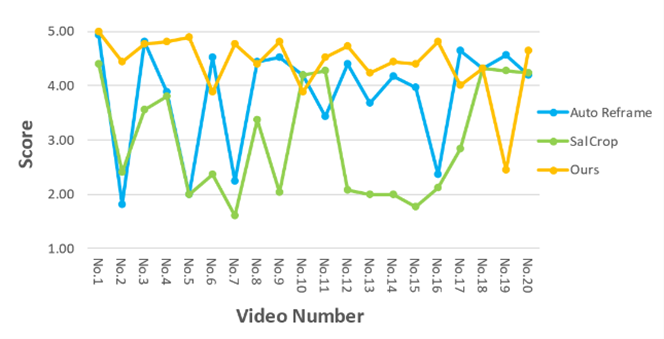

図5 評価実験(テーマA)

図6 入力動画像(テーマB)

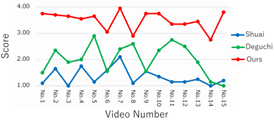

図7 評価実験(テーマB)

EFFECT期待効果

結論

動画像に対して運動量や深度値から主被写体を決定することで,高精度な動画像クロッピング手法を実現した.また,被写体の動きを考慮したシーム算出により,位置ずれと歪みを抑制した高精度なSCを実現した.今後は,これらの手法の更なる精度向上および融合により,より汎用的なリサイズ手法に拡張する.

【参考文献】

[1] Richard Droste, Jianbo Jiao, J. Alison Noble, “Unified Image and Video Saliency Modeling”, In Proceedings of the European Conference on Computer Vision (ECCV), 2020.

[2] Kao Zhang, Yan Shang, Songnan Li, Shan Liu, Zhenzhong Chen, “SalCrop: Spatio-temporal Saliency Based Video Cropping”, IEEE International Conference on Visual Communications and Image Processing (VCIP) demo paper, 2022.

[3] Adobe, “Automatically reframe video for social media channels”, <https:// helpx.adobe.com/premiere-pro/using/auto-reframe.html>

[4] S.Wang, et al. “Multi-Operator Video Retargeting Method Based on Improved Seam Carving”, 2020 IEEE 5th Information Technology and Mechatronics Engineering Conference (ITOEC), pp.1609-1614, 2020.

[5] Shoma Deguchi, et al. “Fast Seam Carving for Video Image Based on Cost Equalisation”, Proceedings of 2022 IEEE 11th Global Conference on Consumer Electronics (GCCE), 2022.

投稿済みの論文

発表論文(4件)

1)

Kaiki Ota, Naoki Kotani,

Satoshi Sugikawa, Yuta Muraki, “Vertical Video Cropping Considering

Multiple Subjects”, 2024 IEEE 13th Global Conference on Consumer

Electronics (GCCE), 2024.

2)

Kyoma Fujiwara, Naoki Kotani,

Satoshi Sugikawa, Yuta Muraki, “High-Precision Video Seam Carving with

Seam Control Based on Motion Analysis”, 2024 IEEE 13th Global Conference

on Consumer Electronics (GCCE), 2024.

3)

大田海生,小谷直樹,杉川智,村木祐太,”複数被写体を考慮した縦型ビデオクロッピング”,情報処理学会

第87回全国大会 講演論文集,2025.

4)

藤原恭雅,小谷直樹,杉川智,村木祐太,”被写体の動きに基づいたシーム制御による高精度な動画像シームカービング”,情報処理学会

第87回全国大会 講演論文集,2025.